https://www.aitimes.com/news/articleView.html?idxno=161703

라이브 비디오 스트림을 즉시 애니메이션으로 변환하는 인공지능(AI) 도구가 나왔다. 기존과는 다른 '단방향 어텐션 모델링(uni-directional attention modeling)' 방식으로 성능을 높였다는 설명이다.

벤처비트는 17일(현지시간) 상하이 AI연구실과 막스 플랑크 정보학연구소, 난양이공대학교 연구진이 라이브 비디오 스트림을 실시간으로 스타일 변환하는 AI 도구 ‘라이브2디프(Live2Diff)’ 논문을 아카이브에 게재했다고 전했다.

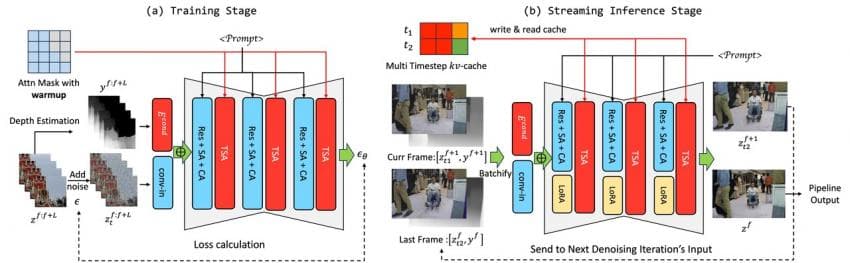

라이브2디프는 라이브 비디오 스트림 처리를 위한 비디오 확산(diffusion) 모델에 단방향 어텐션 모델링을 구현한 첫번째 사례로 소개됐다.

일반적으로 비디오 확산 모델은 기반이 되는 트랜스포머 아키텍처의 기본 구성 요소인 어텐션 메카니즘의 양방향 특성 때문에 라이브 비디오 스트림에 대한 실시간 처리가 불가능하다.

일반적으로 문장 속 단어와 같은 순차 데이터를 학습해 맥락과 의미를 추적하는 트랜스포머 모델은 서로 떨어져 있는 데이터 요소들의 관계를 이해하는 데 어텐션 메커니즘을 사용한다.

이런 트랜스포머의 어텐션 메커니즘을 라이브 비디오에 적용할 경우, 비디오 프레임 간의 관계를 이해하기 위해 과거 프레임과 미래 프레임 모두에 대해 시간적으로 양방향 처리가 필요하다. 특히 미래 프레임을 처리를 위해서는 지연이 불가피하다.

이 문제를 해결하기 위해 라이브2디프는 각 프레임에 대해 미래 프레임 없이 과거 프레임과 몇 개의 초기 워밍업 프레임만 연관시켜 시간이 흘러도 일관성을 유지하는 단방향 어텐션 모델링을 도입했다.

연구진은 "우리의 접근 방식은 미래 프레임 없이도 시간적 일관성과 자연스러움을 보장한다”라며 “이는 실시간 비디오 번역 및 처리를 위한 새로운 가능성을 열어준다"라고 설명했다.

특히 이 기술은 엔비디아 '4090 GPU'와 같은 일반 소비자 하드웨어에서 초당 16프레임의 속도로 비디오를 실시간 온디바이스 처리하도록 최적화됐다.

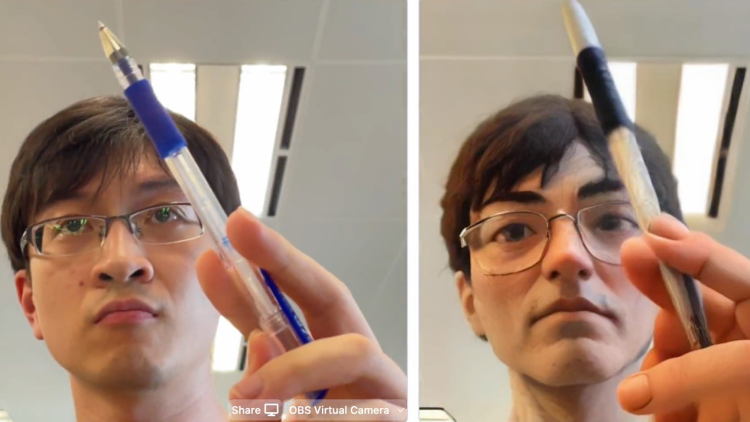

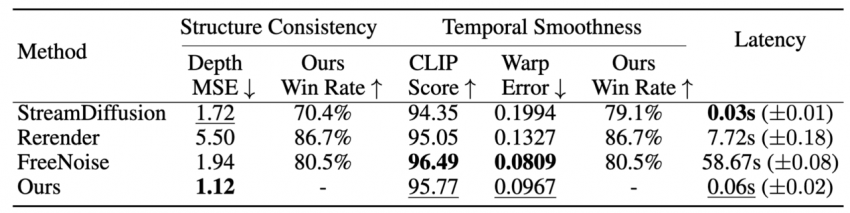

연구진은 실시간 웹캠 입력을 사용해 얼굴을 애니메이션 스타일 캐릭터로 변환하는 라이브2디프의 능력을 시연했다. 광범위한 실험 결과, 라이브2디프가 시간적 일관성과 자연스러움에서 기존 방법을 능가한다는 것을 양적 측정 및 사용자 연구에서 확인했다고 전했다.

라이브2디프는 엔터테인먼트 산업에서 실시간 스트리밍과 가상 이벤트를 재정의할 수 있는 잠재력을 가지고 있다는 평이다.

증강 현실(AR)과 가상 현실(VR) 분야에서 몰입형 경험을 향상할 수 있고, 실시간 스타일 전송을 통해 실시간 비디오 피드에서 현실 세계와 가상 환경 간의 간극을 줄일 수 있다. 또 게임이나 가상 투어, 건축 및 디자인과 같은 전문 분야에서도 응용될 수 있다.

연구진은 라이브2디프의 전체 코드를 곧 오픈 소스로 공개할 계획이다.

https://arxiv.org/html/2407.08701v1

댓글 영역

획득법

① NFT 발행

작성한 게시물을 NFT로 발행하면 일주일 동안 사용할 수 있습니다. (최초 1회)

② NFT 구매

다른 이용자의 NFT를 구매하면 한 달 동안 사용할 수 있습니다. (구매 시마다 갱신)

사용법

디시콘에서지갑연결시 바로 사용 가능합니다.